Współzałożyciel Ethereum, Vitalik Buterin, ostrzega w sprawie ryzyk związanych z nadejściem superinteligentnej AI i potrzebą silnego mechanizmu obronnego.

Uwagi Buterina pojawiają się w momencie, gdy szybki rozwój sztucznej inteligencji budzi coraz większe obawy o jej bezpieczeństwo.

Vitalik Buterin ostrzega: Plan regulacji AI według współzałożyciela Ethereum

W poście na blogu z 5 stycznia Vitalik Buterin przedstawił swoją ideę “d/acc” lub “przyspieszenia obronnego”, gdzie technologia powinna być rozwijana w celu obrony, a nie szkodzenia. To nie pierwszy raz, gdy Buterin mówi o ryzykach związanych ze sztuczną inteligencją. W 2023 roku Buterin powiedział:

„Jednym ze sposobów, w jaki AI może pogorszyć świat, jest (prawie) najgorszy możliwy sposób: może dosłownie spowodować wyginięcie ludzkości.”

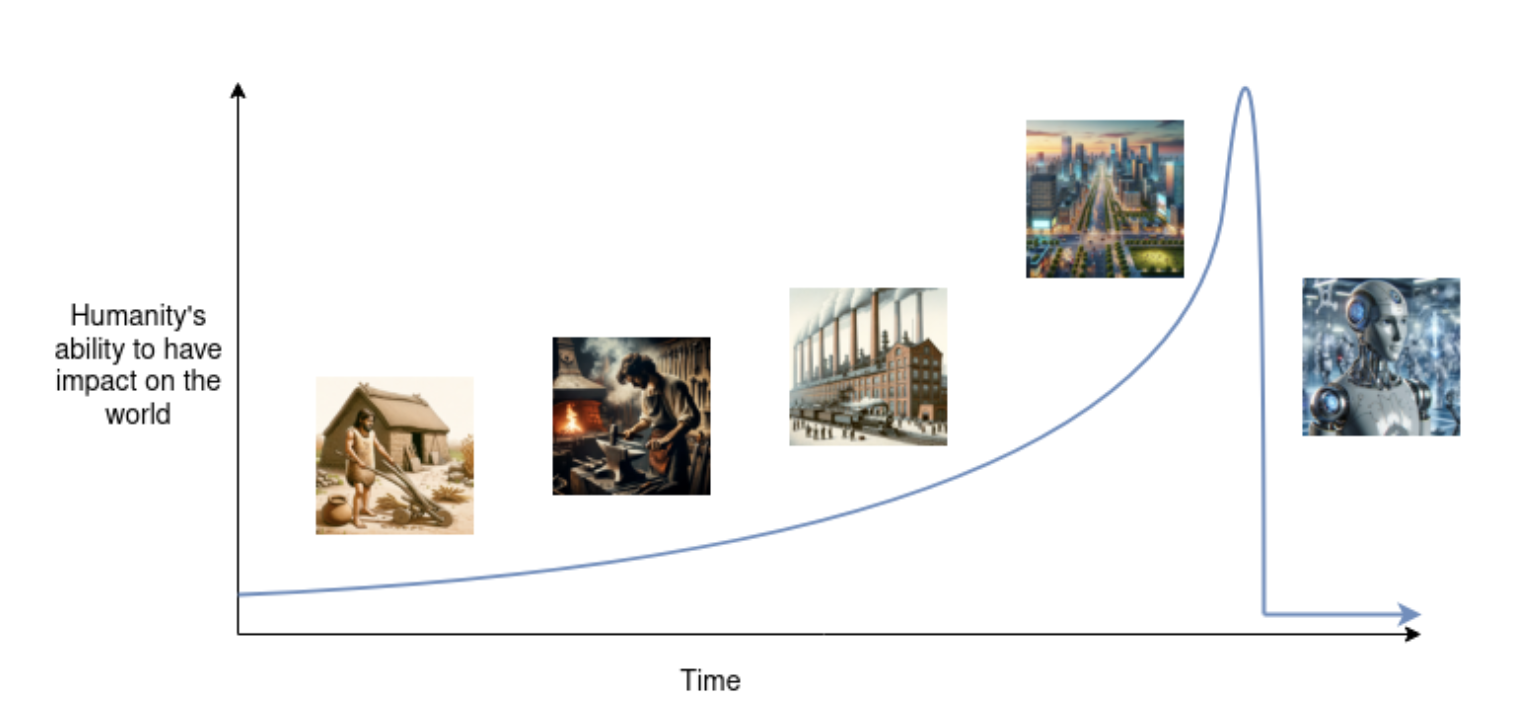

Tymczasem wydaje się, że Buterin teraz kontynuuje swoje teorie z 2023 roku. Według niego superinteligencja może powstać za kilka lat. Buterin wyjaśnił:

„Wygląda na to, że mamy trzy lata do AGI i kolejne trzy do superinteligencji. Jeśli nie chcemy, aby świat został zniszczony lub wpadł w nieodwracalną pułapkę, musimy nie tylko przyspieszać dobre, ale także spowalniać złe.”

Zatem, aby zminimalizować ryzyka związane z AI, Buterin opowiada się za tworzeniem zdecentralizowanych systemów AI, które pozostają ściśle powiązane z ludzkimi decyzjami. Dzięki temu AI pozostaje narzędziem w rękach ludzi, co minimalizuje ryzyko katastrofalnych skutków.

Co więcej Buterin wyjaśnił na przykładzie, jak wojsko może być odpowiedzialne za scenariusz “zagłady AI”. Wykorzystanie AI w wojsku rośnie na całym świecie, co widać na przykładzie Ukrainy i Gazy. Vitalik Buterin ostrzega, że wszelkie regulacje AI, które wejdą w życie, prawdopodobnie wykluczą wojsko, co czyni je znaczącym zagrożeniem.

Ze względu na obawy, współzałożyciel Ethereum przedstawił swoje plany regulacji użycia AI. Powiedział, że pierwszym krokiem w unikaniu ryzyk związanych z AI jest uczynienie użytkowników odpowiedzialnymi. Buterin, podkreślając rolę użytkowników wyjaśnił:

„Choć związek między tym, jak model jest rozwijany, a tym, jak jest używany, jest często niejasny, to użytkownik decyduje, jak dokładnie AI jest używane.”

Jeśli zasady odpowiedzialności nie zadziałają, kolejnym krokiem będzie wprowadzenie “miękkich przycisków pauzy”, które pozwolą na regulację AI i spowolnienie tempa potencjalnie niebezpiecznych postępów. Zatem pauza może być wdrożona poprzez weryfikację lokalizacji AI i rejestrację. Vitalik dodał:

„Celem byłoby mieć możliwość zmniejszenia dostępnej na świecie mocy obliczeniowej o ~90-99% na 1-2 lata w krytycznym okresie, aby dać ludzkości więcej czasu na przygotowanie się.”

Innym podejściem byłoby kontrolowanie sprzętu AI. Buterin wyjaśnił, że sprzęt AI mógłby być wyposażony w chip do jego kontrolowania.

Dla rozwinięcia jego myśli, chip pozwoli systemom AI działać tylko wtedy, gdy co tydzień otrzymają trzy podpisy od międzynarodowych organów. Dodał, że przynajmniej jeden z organów powinien być niezwiązany z wojskiem.

Niemniej jednak Buterin przyznał, że jego strategie mają luki i są tylko ‘tymczasowymi rozwiązaniami’.

Aby zapoznać się z najnowszą analizą rynku kryptowalut przez BeInCrypto, kliknij tutaj.