Dzięki Auto-GPT wkraczamy prosto do świata autonomicznych agentów AI. Mówiąc prościej, jest to potencjalnie przełomowe narzędzie, które pozwala dużym modelom językowym (LLM) myśleć, planować i wykonywać zadania bez udziału człowieka. W tym sensie działa bardziej jak niezależny, rozwinięty ChatGPT. Sztuczna inteligencja na sterydach.

Mówi się nawet o tym, że Auto-GPT to preludium do AGI (Artificial general intelligence). Zamiast jednak zagłębiać się w futurystyczne prognozy, skupmy się na tym, co wiemy. Ten przewodnik analizuje wszystko, co musisz wiedzieć o Auto-GPT, jego możliwościach i tym, jak zmienia ludzką interakcję ze sztuczną inteligencją.

Co to jest Auto-GPT?

Auto-GPT to asystent AI skupiający się na autonomii. Ten eksperymentalny interfejs dla GPT-4 i GPT-3.5 jest zdolny do samodzielnego wykonywania zadań bez konieczności interwencji człowieka. W przeciwieństwie do ChatGPT, który wymaga określonych poleceń, Auto-GPT przejmuje stery, generując własne polecenia do wykonania zadań ustalonych przez użytkownika.

Pomyśl o tym w ten sposób: aby naprawdę wykorzystać moc chatbota AI, takiego jak ChatGPT, musisz zapewnić układankę słowną z zapytaniami, które do niego wpisujesz. W końcu, jakość wyników każdego chatbota AI będzie w dużej mierze zależeć od jakości zapytań. Ale co by było, gdybyśmy mogli to pominąć i pozwolić aplikacji samodzielnie wymyślić najlepsze polecenia? Na domiar tego, może wymyślić kolejne kroki i sposób ich wykonania, iterując je, aż zadanie zostanie skończone.

I nie chodzi tylko o inteligencję, ale także o zaradność. Auto-GPT może uzyskiwać dostęp do stron internetowych i wyszukiwarek, gromadzić dane, a nawet samodzielnie oceniać jakość tych danych. Wszystko, co jest słabe, zostaje odrzucone, a Auto-GPT tworzy nowe podzadanie w celu znalezienia lepszych danych. W ten sposób zyskuje miano autonomicznego agenta AI.

Brzmi intrygująco? Jeśli planujesz wypróbować to samodzielnie, będziesz potrzebować płatnego konta OpenAI. Następnie, pobierz API OpenAI, które będzie działać jako pomost umożliwiający interakcję z GPT-4 i ChatGPT OpenAI.

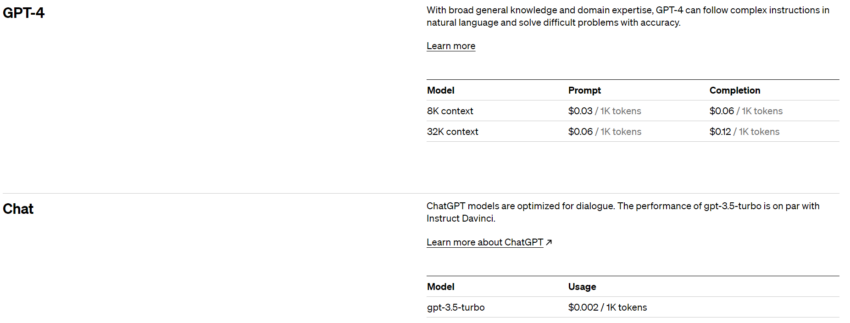

Jeśli chodzi o koszty, wszystko sprowadza się do tokenów – waluty OpenAI dla słów. Jeden token odpowiada mniej więcej czterem znakom lub 0,75 słowa. Liczba tokenów wysłanych jako podpowiedź i otrzymanych z powrotem określa całkowity koszt.

Krótkie wprowadzenie do AutoGPT

W przeciwieństwie do ChatGPT, do którego można uzyskać dostęp bez wysiłku, logując się na swoje konto OpenAI i wykonując kilka podstawowych kroków, konfiguracja Auto-GPT na komputerze wymaga nieco bardziej złożonego procesu. Oto co należy zrobić:

- Krok 1: Po pierwsze, upewnij się, że masz podstawowe narzędzia. Obejmuje to Python 3.8 (lub nowszy) i klucze API OpenAI. Linki do ich pobrania można znaleźć na stronie GitHub Auto-GPT.

- Krok 2: Zainstalowałeś narzędzia? Świetnie! Teraz przejdź do GitHub, kliknij “Code” i pobierz plik Zip. Wybierz drzewo “Stable” po lewej stronie – drzewo “Master” może być nieco zbyt złożone.

- Krok 3: Otwórz Power Shell i uruchom ten kod: ‘git clone https://github.com/Torantulino/Auto-GPT.git’.

- Krok 4: Teraz przejdź do katalogu projektu za pomocą: ‘cd Auto-GPT’.

- Krok 5: Gdy już znajdziesz się we właściwym miejscu, zainstaluj biblioteki za pomocą tego polecenia: ‘pip install -r requirements.txt’.

- Krok 6: Na koniec zmień nazwę “env. template” na “.env” i wprowadź swój OPENAI_API_KEY.

I to wszystko! Agent jest teraz gotowy do działania. Nazwij swojego bota i przystąp do działań.

Jeśli chodzi o interfejsy API OpenAI, w chwili pisania tego tekstu dostępne są dwie opcje do wyboru – jedna z kontekstem 8 000, a druga z kontekstem 32 000. Jak widać na poniższym obrazku, ceny zależą od wybranego modelu i mogą być dość wysokie, jeśli nie będziesz ostrożny. Omówimy te wady szczegółowo w dalszej części przewodnika.

Nie musisz jednak martwić się o koszty. Możesz ustawić limity wydatków na API. Jeśli ustawisz miękki limit, OpenAI wyśle wiadomość e-mail z powiadomieniem o osiągnięciu ustawionego limitu. Twardy limit jest bardziej skuteczny, ponieważ OpenAI automatycznie kończy wszystkie usługi związane z API po jego osiągnięciu.

Czym jest “kontekst” w dużych modelach językowych?

Dla tych, którzy nie są na bieżąco, “kontekst” odnosi się tutaj do poprzedzającego tekstu lub informacji, których model używa do generowania swoich odpowiedzi. Tak jak pamiętasz co zostało powiedziane w rozmowie, możesz odpowiednio zareagować. W ten właśnie sposób działa GPT-4 i inne modele językowe. Wykorzystują one to, co nazywamy “kontekstem” – cały tekst, który pojawił się wcześniej – aby dowiedzieć się, co powiedzieć dalej.

Wyobraź sobie, że pamiętasz tylko dwa ostatnie zdania rozmowy. Byłoby to dość ograniczające. Tak więc te modele sztucznej inteligencji mają “okno kontekstowe” wykonujące rolę pamięci krótkotrwałej modelu.

Od maja 2023 GPT-4 jest w stanie obsłużyć ponad 25 000 słów tekstu, co stanowi znacznie dłuższy “kontekst” niż ten oferowany przez poprzednie modele GPT.

Możliwości Auto-GPT

Pomyśl o Auto-GPT jak o zaradnym asystencie AI. Jeśli zadanie obejmuje przeglądanie Internetu lub wyszukiwanie danych, Auto-GPT stale dostosowuje swoją strategię, aż misja zostanie wykonana.

Przypomina to posiadanie osobistego asystenta zdolnego do wykonywania różnych zadań, od analizy rynku i obsługi klienta po finanse i nie tylko.

Oto cztery kluczowe aspekty, które napędzają Auto-GPT:

- Architektura: Auto-GPT wykorzystuje siłę modeli GPT-4 i GPT-3.5 jako swojego silnika poznawczego, wspomagając go w myśleniu i rozwiązywaniu problemów.

- Możliwości autonomiczne: Jest to mechanizm samodoskonalenia Auto-GPT. Może on zastanowić się nad swoją wydajnością, wykorzystać poprzednie wyniki i swoją historię, aby zapewnić bardziej precyzyjne działanie.

- Zarządzanie pamięcią: Będąc zintegrowanym z wektorowymi bazami danych, formą przechowywania pamięci, Auto-GPT utrzymuje kontekst i podejmuje bardziej świadome decyzje. To jak archiwum pamięci długoterminowej bota.

- Wielofunkcyjność: Dzięki możliwościom takim jak manipulowanie plikami, przeglądanie stron internetowych i gromadzenie danych, Auto-GPT jest wielowymiarowym narzędziem, będącym ewolucją wcześniejszych osiągnięć AI.

Tak więc Auto-GPT jest w zasadzie robotem bez fizycznej formy, który wykorzystuje sztuczną inteligencję i duże modele językowe do obsługi szerokiej gamy zadań, uczenia się na podstawie swojej przeszłości i ciągłego zwiększania wydajności.

Ważne jest jednak, aby pamiętać, że to nie w pełni odzwierciedla rzeczywiste możliwości, jakie Auto-GPT może obecnie zaoferować. Przyjrzyjmy się zatem niektórym ograniczeniom i wyzwaniom, przed którymi stoi Auto-GPT w swojej obecnej iteracji.

Ograniczenia Auto-GPT

Czynnik kosztów

Wdrożenie GPT-4, które tworzy ramy strukturalne Auto-GPT, wiąże się ze znacznymi kosztami. Każdy “kognitywny” krok w sekwencji zadań wyzwala symboliczną opłatę za dedukcyjne przetwarzanie GPT-4 i dalsze podpowiedzi.

Przy oknie kontekstowym 8000 koszt wynosi 0,03 USD za 1000 tokenów dla polecenia i 0,06 USD za 1000 tokenów dla wyników. Zakładając maksymalne wykorzystanie okna kontekstowego, podzielonego na 80% polecenia i 20% wyników, każdy krok wiąże się z opłatą w wysokości 0,288 USD.

Przeciętne proste zadanie może wymagać nawet 50 kroków (lub więcej). Oznacza to, że jedno stosunkowo proste zadanie może kosztować aż (0,288 USD x 50=) 14,40 USD. Ten wysoki koszt operacyjny sprawia, że Auto-GPT, w obecnej formie, jest nieopłacalny dla wielu potencjalnych użytkowników i podmiotów..

Problem “nieskończonej pętli”

Można założyć, że jeśli Auto-GPT potrafi usprawnić przepływ pracy i skutecznie radzić sobie z zadaniami, to znaczne opłaty za API OpenAI mogą być postrzegane jako uzasadniony wydatek. Ale nie zawsze tak jest.

Sprawdź subreddity takie jak r/autogpt lub jakiekolwiek podobne forum internetowe, a zobaczysz, że wielu użytkowników narzeka na sprawność. Nawet w oparciu o nasze własne doświadczenia, Auto-GPT często wpada w pętle przetwarzania zamiast produkować obiecane rozwiązania.

Pomimo zaawansowanych funkcji, rozwiązywanie problemów przez Auto-GPT jest ograniczone przez wąski zakres oferowanych funkcji i wciąż niedoskonałe zdolności rozumowania GPT-4.

Kod źródłowy Auto-GPT wskazuje na ograniczony zestaw funkcji, w tym wyszukiwanie stron internetowych, obsługę pamięci, interakcję z plikami, wykonywanie kodu i generowanie obrazów, co zwęża spektrum zadań, które może kompetentnie obsłużyć. Co więcej, chociaż GPT-4 wykazał poprawę w stosunku do swojego poprzednika, jego zdolność rozumowania jest nadal daleka od ideału. Często skutkuje to pętlami zamiast rozwiązań.

Zastosowanie Auto-GPT

Auto-GPT wykracza poza granice “zwykłych” chatbotów AI, takich jak ChatGPT. Na przykład, ma potencjał do nadzorowania i wdrażania kompletnego rozwoju aplikacji. Podobnie, w biznesie i zarządzaniu, Auto-GPT może autonomicznie zwiększyć wartość netto firmy, analizując jej operacje i dostarczając wnikliwych zaleceń dotyczących ulepszeń.

Zdolność Auto-GPT do uzyskiwania dostępu do Internetu umożliwia mu wykonywanie zadań, takich jak badania rynku lub porównywanie produktów w oparciu o określone kryteria. Co więcej, Auto-GPT potrafi być samodoskonalący się, zdolny do tworzenia, oceniania, przeglądania i testowania aktualizacji własnego kodu, potencjalnie zwiększając swoją wydajność i możliwości. Sztuczna inteligencja ma również potencjał do przyspieszania proces tworzenia doskonałych LLM, kładąc podwaliny pod następną generację agentów AI.

Przypadki użycia Auto-GPT

Od tworzenia podcastów i analizowania akcji po pisanie oprogramowania i rozwijanie większej liczby botów AI – użytkownicy na całym świecie wykorzystują Auto-GPT do kreatywnego wykorzystania w różnych dyscyplinach. Niektóre z najczęstszych zastosowań Auto-GPT:

- Tworzenie stron internetowych

- Tworzenie blogów i artykułów przy minimalnym nakładzie pracy

- Tworzenie skutecznych strategii marketingowych

- Automatyzacja interakcji użytkownika, takich jak recenzje produktów lub książek

- Projektowanie graficzne przy użyciu generatorów obrazów ai, takich jak DALL-E 2 i Midjourney.

- Rozwój interfejsów konwersacyjnych i chatbotów

Auto-GPT a inne narzędzia AI

Auto-GPT nie jest jedynym w swoim rodzaju autonomicznym agentem AI. Istnieje wiele innych, z których każdy ma swój urok i ograniczenia. Oto trzy najpopularniejsze alternatywy:

BabyAGI

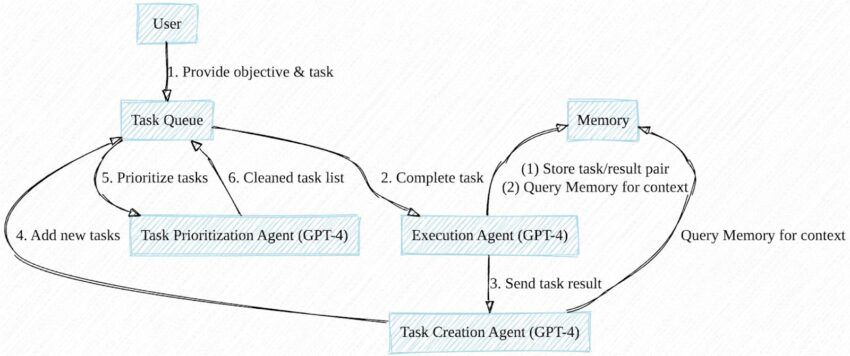

Podobnie jak Auto-GPT, BabyAGI, pomysł Yohei Nakajimy, jest również hostowany na GitHub. Automatycznie generuje, priorytetyzuje i wykonuje zadania zgodne z ustalonym celem. Do uzyskania dostępu i korzystania z tego narzędzia potrzebne jest oprogramowanie Docker i klucz API z OpenAI lub Pinecone.

U podstaw BabyAGI leży model językowy współdziałający z listą zadań. Przechowuje ukończone zadania w bazie danych, służąc jako “pamięć” modelu dla kontekstu podczas formułowania i wykonywania nowych zadań. Chociaż podstawowy skrypt nie ma możliwości wyszukiwania w Internecie ani autonomicznego wykonywania kodu, zostały one wprowadzone w wersjach pochodnych.

Microsoft JARVIS

Microsoft JARVIS, znany również jako HuggingGPT, to system modeli multi-AI, w którym modele GPT z OpenAI działają jako kontroler.

JARVIS zawiera różne modele open-source do przetwarzania obrazów, wideo, audio i innych. Może łączyć się z Internetem i uzyskiwać dostęp do plików. Podobnie jak BabyAGI & Auto-GPT, ocenia zadania i wybiera najbardziej odpowiedni model do ich wykonania.

AgentGPT

AgentGPT jest internetowym rozszerzeniem koncepcji Auto-GPT/BabyAGI. Autonomicznego agenta można uruchomić za pośrednictwem przeglądarki, postępując zgodnie z instrukcjami.

Od ostatniej aktualizacji, AgentGPT posiada następujące funkcje:

- Pamięć długoterminowa oparta na bazie danych

- Przeglądanie stron internetowych i interakcja z witrynami i osobami

- Zapisywanie przebiegu pracy agenta

Wpływ Auto-GPT na przyszłość sztucznej inteligencji

Auto-GPT i podobne serwisy prawdopodobnie stanowią kolejną fazę ewolucji sztucznej inteligencji. W odpowiednim czasie zaczniemy być świadkami bardziej pomysłowych, wyrafinowanych, różnorodnych i praktycznych narzędzi AI. Postępy te mogą potencjalnie zmienić sposób, w jaki pracujemy, spędzamy wolny czas i komunikujemy się. W izolacji nie oferuje to rozwiązań dla wyzwań związanych z generatywną sztuczną inteligencją. Obejmują one niespójność wyników, możliwe naruszenie praw własności intelektualnej, a nawet potencjalne niewłaściwe wykorzystanie sztucznej inteligencji do rozpowszechniania stronniczych lub szkodliwych treści.

Jeśli chodzi o zagrożenia związane z ewolucją agentów AI do poziomu superinteligencji, fizyk i autor bestsellerów Max Tegmark opisał tę możliwość dość zwięźle w swojej książce Life 3.0 z 2017 roku.

“Prawdziwym zmartwieniem nie jest złośliwość, ale kompetencje. Superinteligentna Al jest z definicji bardzo dobra w osiąganiu swoich celów, niezależnie od tego, jakie one są, więc musimy upewnić się, że jej cele są zgodne z naszymi”.