Firma macierzysta ChatGPT, OpenAI, uruchomiła zespół ds. gotowości w celu oceny zagrożeń stwarzanych przez modele sztucznej inteligencji (AI).

Podczas gdy modele AI mogą zmienić ludzkość na lepsze, stwarzają one szereg zagrożeń. Dlatego też rządy są zaniepokojone zarządzaniem ryzykiem związanym z tą technologią i chatbotami typu ChatGPT.

Funkcje zespołu ds. gotowości OpenAI, twórców ChatGPT

W poście na blogu OpenAI ogłosiło uruchomienie zespołu ds. gotowości. Zespół będzie pracował pod kierownictwem Aleksandra Madry’ego, dyrektora Massachusetts Institute of Technology’s Center for Deployable Machine Learning.

Granice sztucznej inteligencji stwarzają pewne zagrożenia, takie jak:

- Zindywidualizowana perswazja

- Bezpieczeństwo cybernetyczne

- Zagrożenia chemiczne, biologiczne, radiologiczne i nuklearne (CBRN)

- Autonomiczna replikacja i adaptacja (ARA)

Ponadto istnieje ryzyko dezinformacji i rozprzestrzeniania plotek za pośrednictwem sztucznej inteligencji.

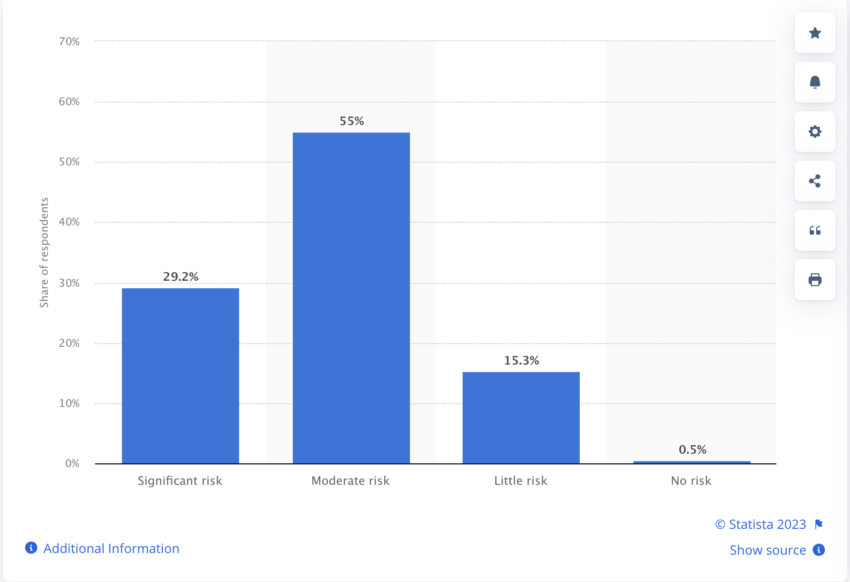

Poniższy zrzut ekranu pokazuje odsetek profesjonalistów, którzy uważają, że generatywna sztuczna inteligencja (AI) stwarza zagrożenie dla bezpieczeństwa i dezinformacji na całym świecie.

Rząd Wielkiej Brytanii definiuje granice AI jako:

“Wysoce wydajne modele AI ogólnego przeznaczenia, które mogą wykonywać różnorodne zadania i dorównywać lub przewyższać możliwości obecne w dzisiejszych najbardziej zaawansowanych modelach.”

Zespół ds. gotowości OpenAI skupi się na zarządzaniu ryzykiem spowodowanym przez wyżej wymienione katastrofy. Firma macierzysta ChatGPT nazywa ten projekt swoim wkładem w nadchodzący globalny szczyt AI w Wielkiej Brytanii.

Ponadto w lipcu liderzy AI, tacy jak OpenAI, Meta, Google i inni, zobowiązali się do bezpieczeństwa i przejrzystości w rozwoju AI w Białym Domu.

Wczoraj BeInCrypto poinformowało, że premier Wielkiej Brytanii Rishi Sunak nie chce spieszyć się z regulacją sztucznej inteligencji. Obawia się on między innymi, że ludzkość może całkowicie stracić kontrolę nad AI.

Aby zapoznać się z najnowszą analizą Bitcoina (BTC) przez BeInCrypto, kliknij tutaj.