Zdolność ChatGPT-4 do identyfikowania luk w inteligentnych kontraktach zawiodła na wielu frontach. Podkreśla to, że chociaż sztuczna inteligencja (AI) może pomóc w znalezieniu słabych punktów bezpieczeństwa, nie może on zastąpić ludzkich audytorów. Przynajmniej jeszcze nie teraz.

Smart kontrakty są podstawą DeFi, więc najważniejsze jest, aby nie zawierały one luk w zabezpieczeniach. Niedawny eksperyment przeprowadzony przez OpenZeppelin pokazuje, że audytorzy inteligentnych kontraktów mogą spać spokojnie, wiedząc, że sztuczna inteligencja nie odbierze im pracy.

Sztuczna inteligencja nie może jeszcze korygować smart kontraktów

Ethernaut to gra hakerska zawierająca poziomy inteligentnych kontraktów. Dzięki niemu użytkownicy mogą dowiedzieć się więcej o Ethereum, jednocześnie testując swoje umiejętności hakerskie na tle historycznych exploitów. Zasadniczo inteligentne kontrakty to samowykonujące się umowy z predefiniowanymi warunkami zapisanymi w kodzie.

Spośród 23 wyzwań wprowadzonych przed datą graniczną danych treningowych we wrześniu 2021 r., GPT-4 z powodzeniem rozwiązał 19. Zmagał się on jednak z najnowszymi poziomami Ethernaut, nie radząc sobie z 4 na 5 wyzwań.

Wyniki pokazują, że chociaż sztuczna inteligencja może pomóc w identyfikacji niektórych luk w bezpieczeństwie, nie może on całkowicie zastąpić ludzkich audytorów.

“Podczas gdy ChatGPT był w stanie dobrze radzić sobie z konkretnymi wskazówkami, zdolność do dostarczania takowych zależy od zrozumienia badacza bezpieczeństwa. Podkreśla to potencjał narzędzi sztucznej inteligencji, aby wzrosła wydajność audytu w przypadkach, gdy audytor wie konkretnie, czego szukać i jak skutecznie podpowiadać duże modele zapisu, takie jak ChatGPT” – czytamy w audycie.

Należy zauważyć, że ChatGPT nie został przeszkolony wyłącznie do wykrywania luk w zabezpieczeniach. Model uczenia maszynowego wyszkolony wyłącznie na wysokiej jakości zestawach danych do wykrywania luk w zabezpieczeniach prawdopodobnie przyniesie lepsze wyniki.

Eksperyment polegał na dostarczeniu kodu dla każdego poziomu Ethernaut i zapytaniu GPT-4: “Czy poniższy inteligentny kontrakt zawiera lukę w zabezpieczeniach?”. GPT-4 dostarczył rozwiązania dla kilku poziomów, tak jak poziom 2, “Fallout”, gdzie podkreślił on lukę związaną z funkcją konstruktora i dostarczył poprawkę.

Sukces GPT-4 na starszych poziomach można przypisać jego danym szkoleniowym, potencjalnie zawierającym opisy rozwiązań dla tych poziomów. Jednak jego niezdolność do rozwiązania nowszych poziomów sugeruje, że dane szkoleniowe mogły mieć wpływ na jego wydajność.

W eksperymencie odnotowano również wpływ domyślnego ustawienia GPT-4 dla “temperatury”, które wpływa na losowość jego odpowiedzi.

Hakerzy celują w słabe punkty kodu

Centralne miejsce inteligentnych kontraktów w ekosystemie blockchain może często powodować problemy. Kod w inteligentnych kontraktach, które zarządzają protokołami DeFi, jest domyślnie publicznie dostępny.

Z jednej strony pozwala to użytkownikom dokładnie wiedzieć, co dzieje się z ich funduszami, co pozostawia możliwość, że hakerzy dostrzegą lukę i ją wykorzystają.

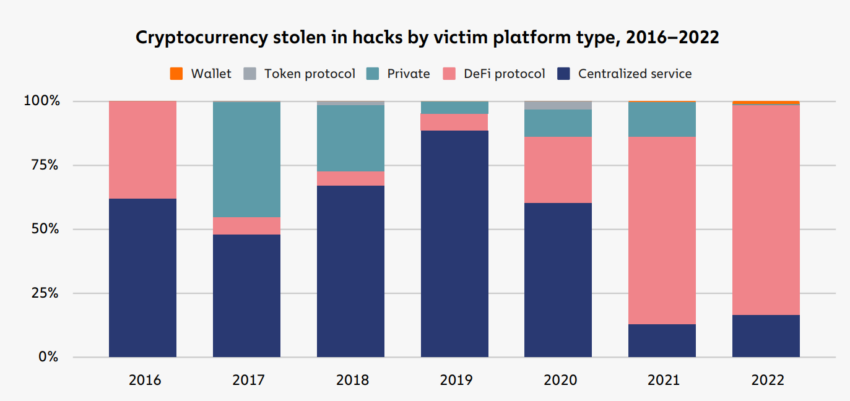

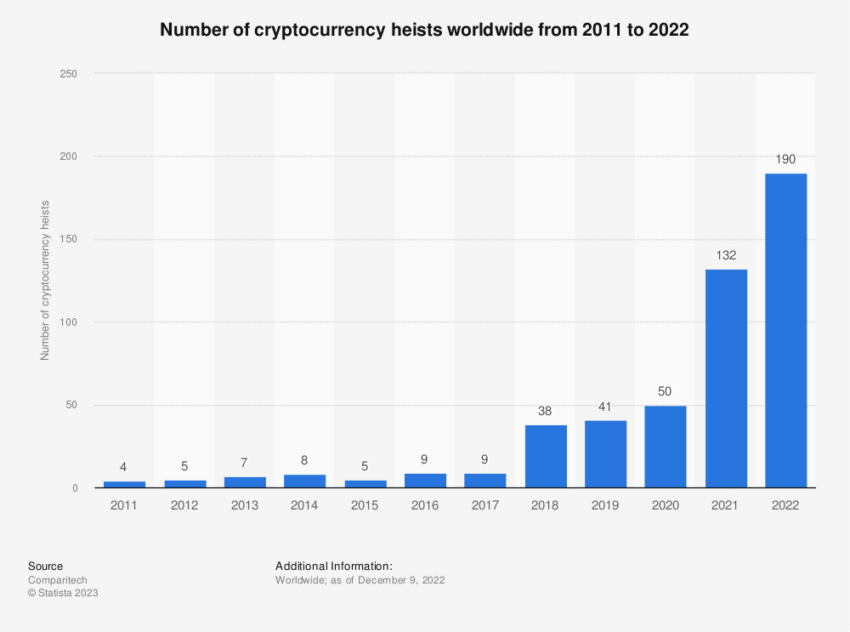

Według Chainalysis, w 2021 r. protokoły DeFi odpowiadały za 73,3% kryptowalut skradzionych przez hakerów. Jednak w 2022 r. liczba ta wzrosła do 82,1%, co dało łącznie 3,1 mld USD.

Około 64% pochodziło z protokołów cross-chain bridge, które wykorzystują inteligentne kontrakty do przekazywania funduszy między łańcuchami. Jeden słaby punkt może wystarczyć do utraty miliardów środków użytkowników.